编辑:Panda

因为基准测试成绩与实际表现相差较大,近期开源的 Llama 4 系列模型正陷入争议的漩涡之中,但有一点却毫无疑问:MoE(混合专家)定然是未来 AI 大模型的主流范式之一。从 Mixtral 到 DeepSeek 再到 Qwen2.5-Max 以及 Llama 4,越来越多的 MoE 架构模型正在进入世界最前沿模型之列,以至于英伟达也已开始针对 MoE 架构设计和优化自家的计算硬件。

但是,MoE(尤其是大规模 MoE)也会给 AI 基础设施带来不一样的挑战。昨天,在 AI 势能大会下午的 AI 基础设施峰会上,阿里云智能集团副总裁、阿里云智能计算平台事业部负责人汪军华就谈到了 MoE 架构特有的一些困难,包括 token drop 选择对吞吐的影响、在路由专家与共享专家之间考虑效率和效果的权衡、专家的选取数量和比例等。

汪军华表示 AI 范式正在向 MoE 和推理模型演进

阿里云已经在解决这些难题上取得了重大进展。峰会上,针对 MoE 架构的模型,阿里云宣布基于 PAI-DLC 云原生分布式深度学习训练平台推出了FlashMoE,这是一款支持超大规模 MoE 混合精度训练的高性能训练框架,具有多种强大特性,包括支持多种 token 路由策略、支持上下文并行与张量并行解耦等。

当然,阿里云在 AI 基础设施上的布局远不限于 MoE。无论是硬件算力的投入,还是一体化的训练和推理服务,它都在用硬核实力夯实自己的领先地位。在这场 AI 基础设施的竞赛中,阿里云已然抢占先机。

从算力到安全

阿里云这样构建 AI 基础设施

从算力基础到弹性灵活的解决方案,再到存储与网络技术,以及至关重要的安全能力,阿里云正在不断演进面向 AI 时代的基础设施,以提高其产品力和用户体验。

首先,在基础算力方面,阿里云宣布ECS 第 9 代 Intel 企业级实例正式开启商业化,其基于英特尔第六代至强处理器 GNR,搭配阿里云最新 CIPU 架构,可让集群性能相对前代提升最高达 20%,同时价格较上代再降 5%。

今年也是阿里云弹性计算 15 周年,AI 驱动的阿里云基础设施将持续面向更高性能、更稳定的架构和产品深入演进。

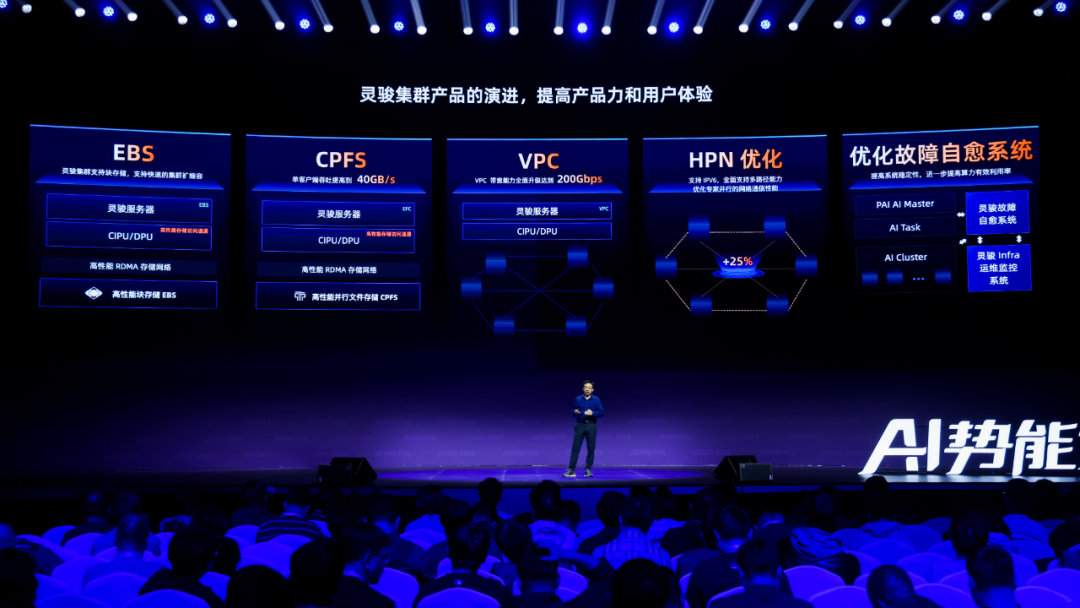

在强大算力的基础上,阿里云还在对灵骏集群不断进行优化。阿里云智能集团副总裁、阿里云智能弹性计算、存储产品线负责人吴结生表示:「我们针对 AI 负载进行了大量优化,把灵骏集群构造成了云超级计算机。」总结起来,灵骏集群的技术体系包含 4 个创新点,包括 HPN 高性能网络、CPFS 高性能文件存储、定制化的 AI 服务器以及强大的故障检测能力。

首先,在网络技术方面,阿里云设计的HPN 7.0高性能网络架构是灵骏集群的核心网络技术,能让机器更高效、更紧密的合作。实际效果上,利用 HPN7.0 高性能网络架构,可实现单集群10 万张 GPU 卡互联,同时提供 3.2T 跨机带宽。

其次,值得一提的是灵骏管控和自愈系统,这能降低故障频次,缩短故障恢复时间,从而增强集群的稳定性,提高算力的使用率 ——在万卡级超大规模训练中,一个月内灵骏 GPU 集群有效训练时长占比超过 93%。

为了保证 AI 业务稳定,算力很重要,高性能且可靠的存储也必不可少。对此,阿里云给出的解答是CPFS(Cloud Parallel File Storage)高性能存储与OSS(Object Storage Service)对象存储服务。

其中,CPFS 适用于高性能计算,支持对数据毫秒级的访问和百万级 IOPS 的数据读写请求,能实现 40 GB/s 的单客户端吞吐性能。

CPFS 还针对 AI 应用进行了优化,在实现高性能并行的同时,还支持端侧缓存和分层存储(包括 KV Cache),从而能高效率和低成本地满足 AI 的训推需求。

OSS 则适用于存储大量非结构化数据,适用于多种计算引擎和 AI 框架,具有海量、安全、易集成、低成本、高可靠的优势。在 AI 基础设施峰会上,阿里云宣布推出高性能的OSSFS 2.0,这是一款专门用于通过挂载方式高性能访问 OSS 的客户端,它具备出色的顺序读写能力,可充分发挥 OSS 的高带宽优势。此外,阿里云还宣布首次将缺省 100 Gbps 吞吐性能扩展到了海外(新加坡)。OSS 同城冗余也已在吉隆坡上线,现已覆盖全球 12 个地域。

阿里云也为 CPFS 和 OSS 之间的数据流动构建了高速、高带宽的通道,使训练或推理框架可以通过文件系统的接口访问 OSS。

安全与稳定性同样也是许多 AI 应用开发者关注的核心问题之一,而阿里云已经构建了一整套用以保障算力稳定供给和数据安全的体系,其中包括 20 多款云产品和近百项可一键开启的安全能力。

面向 MoE 结构和推理模型

AI 范式正在演进

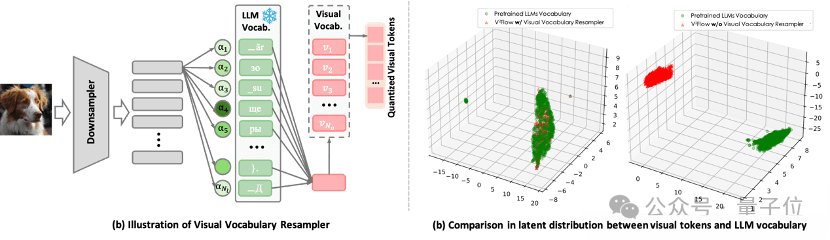

正如开篇所说,MoE 模型架构与推理模型正在不断推动 AI 训推的范式升级,在本次发布上,阿里云人工智能平台 PAI 针对性地推出一系列新能力。

在模型构建方面,针对推理模型,阿里云推出了 PAI-Chatlearn 和 Post-training on PAI-DLC。其中前者是一种支持 RLHF、DPO、OnlineDPO、GRPO 等多种强化学习算法的大规模对齐训练框架,同时也支持用户自己开发的强化学习算法,并且适配 Megatron、vLLM、DeepSpeed 等多种框架。不仅如此,PAI-Chatlearn 还是开源的。而后者则包含 SFT 等后训练能力,支持 Ray on DLC、统一调度、Serverless、Ray Dashboard 和开发机等功能。

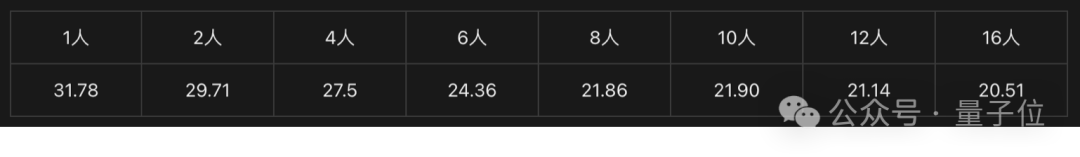

而对于 MoE 模型,前文已经提到了基于 PAI-DLC 的 FlashMoE,其实际表现可说是相当亮眼:在万卡规模上,可将 MoE 训练的 MFU(模型 Flops 利用率)提升到 35-40%。

而在推理加速方面,阿里云同样没有落下。直接上数据。

首先,阿里云推出的全新模型权重服务将 1-100 节点的冷启动速度提升了21倍;如果从 50 个节点扩容到 100 个节点,则分布式推理系统的规模化扩容效率可提升12 倍。

而基于 KV Cache 的分布式推理服务 PAI-EAS 可将千万级活跃用户场景的 KV Cache 命中率提升10 倍!基于 3FS 的存储系统 IO 效率获得了大幅提升(读吞吐提升了43%,写吞吐提升了27%)。

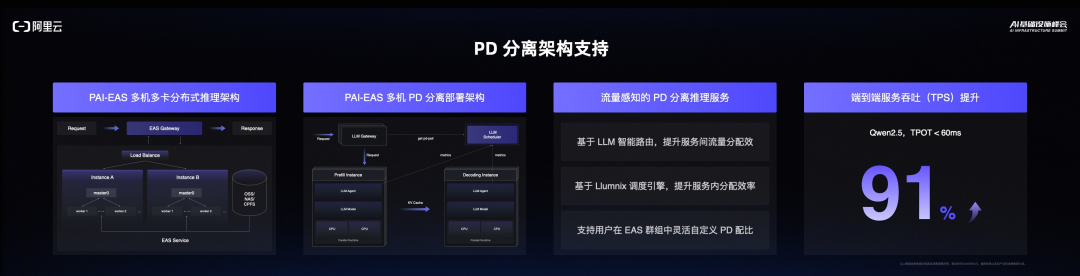

另外,PAI-EAS 具备负载感知的 PD 分离架构,端到端服务吞吐提升91%。

针对 MoE 模型,阿里云宣布推出了针对性的分布式推理引擎Llumnix,通过在请求层面、请求内和硬件并行策略方面的精心设计,相比于 Round-robin 请求调度方案,可将 TTFT(首 token 延迟)降低92%(P99),将 TPOT(每输出 token 延迟)降低15%(P99)。

此外,阿里云也对云原生大数据服务 MaxCompute 进行了全面的 AI 升级,发布了AI Function,可支撑用户构建 Data+AI 一体化工作流。

同时,阿里云在会上宣布大数据 AI 产品全面拥抱MCP,大数据开发治理平台 DataWorks 发布基于 MCP 的 Agent 服务,DataWokrs 和 Hologres 发布了 MCP Server。

智能时代的数据库

让数据和 AI 更近

有了高效算力和平台,要创造足够好的 AI 应用,数据也是必不可少的一环。正如阿里云智能集团副总裁、阿里云智能数据库产品事业部负责人李飞飞说的那样:数据、算法、算力是智能时代的三大要素。因此,对数据库范式的革新也必不可少。那么智能时代对数据库的最核心需求是什么呢?李飞飞认为是「对多模态数据的智能化管理」。

为此,阿里云正在不断创新。此次峰会上,阿里云重点介绍了其数据库产品的一系列重磅升级。

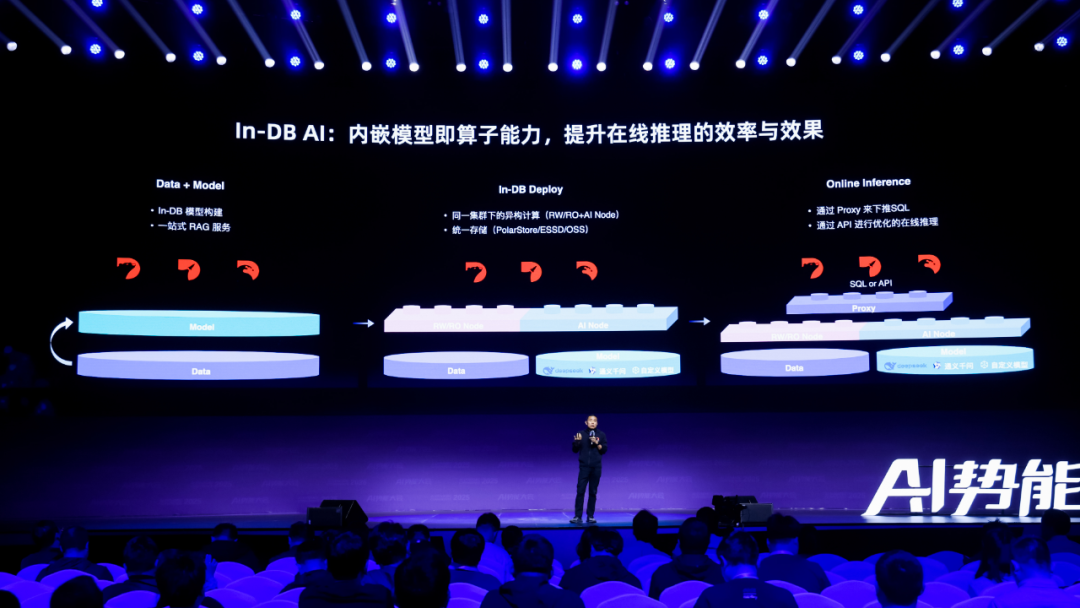

首先,阿里云宣布实现了模型即算子(Model as an Operator)的 In-DB AI 功能,也就是说可以将模型作为算子直接内嵌到数据库中。这样做具有明显的好处,包括能使用更低的推理成本获得同等的 AI 能力、可以通过 SQL 语句轻松调用、可避免企业私有数据出域。李飞飞表示,阿里云会在今年内让 PolarDB、Lindorm 和 AnalyticDB 都支持 In-DB AI。

阿里云在数据库方面的另一大重要举措是采用了 Data+AI 的设计理念。具体来说,通过统一 CPU 和 GPU 资源池,瑶池数据库实现了资源池化,支持分时分片弹性调度,进而帮助客户降本增效。

此外,阿里云还宣布将 Tair 从互联网架构演进成了面向 AI 时代的架构:通过基于 Tair 内存池的 KV Cache 多级管理,可为大模型推理提供高效的 KV Cache 存储和复用。同时,Tair KVCache还支持多租隔离、资源配额、故障恢复等企业级管理能力。

当然,阿里云数据库产品的升级之路还将继续向前。阿里云透露将于今年下半年发布全球首款基于CXL(Compute Express Link)交换机的数据库专用服务器。CXL 高速互联技术可以进一步提升三层解耦架构下计算与内存之间的通信带宽与效率。与传统的 RDMA 高速网络相比,CXL 技术可将内存交互的性能提升一个数量级。

用 AI 基础设施支撑智能未来

阿里云准备好了

在 AI 迅猛发展的今天,强大的算力已成为驱动创新的核心动力。阿里云深刻洞察这一趋势,持续加大在 AI 基础设施领域的投入,致力于为全球用户提供高效、稳定的计算资源。

现在,依托于在 AI 基础设施上的创新和投入,阿里云已为开发者和企业搭建了一个坚实的平台,使他们能够专注于算法创新和应用开发,而无需过度关注底层计算资源的限制。而这正是 AI 大规模应用的重要基础。

正如吴结生说的那样:「云计算是一种公共服务。随着 AI 的发展,智能会变成一种资源,就像水和电一样。这样一来,token 就变成了一种商品。云上的算力正在以这种公共服务的方式给大家提供这种商品,从而普及 AI,让 AI 走进千行百业,让 AI 实现大众化和规模化。」

而当智能成为一种「资源」,基础设施的供给能力,也将决定 AI 能走多远、飞多高。

阿里云正携手企业和开发者,共同迈向智能化的未来。在这场奔赴未来的基建竞速中,阿里云,已在路上。

关注飞天发布时刻,及更多精彩发布内容: https://summit.aliyun.com/apsaramoment

©(文:机器之心)